Künstliche Intelligenz (KI) wirkt oft wie Magie. Sprachmodelle wie ChatGPT, Claude oder Gemini schreiben Texte, lösen Aufgaben, übersetzen Sprachen oder dichten Reime – und das oft besser als viele Menschen. Doch wie entsteht diese scheinbare „Intelligenz“ eigentlich?

In diesem Beitrag erfährst du, wie Sprachmodelle durch Training lernen, warum das so schwer zu verstehen ist – und was das mit Milliarden Zahlen zu tun hat.

Was macht ein Sprachmodell?

Ein Sprachmodell wie GPT-4 oder Claude ist darauf trainiert, das nächste Wort vorherzusagen. Es bekommt also einen Text wie:

„Die Hauptstadt von Frankreich ist…“

und soll möglichst richtig mit „Paris“ antworten.

Das klingt einfach – doch hinter den Kulissen passiert Erstaunliches.

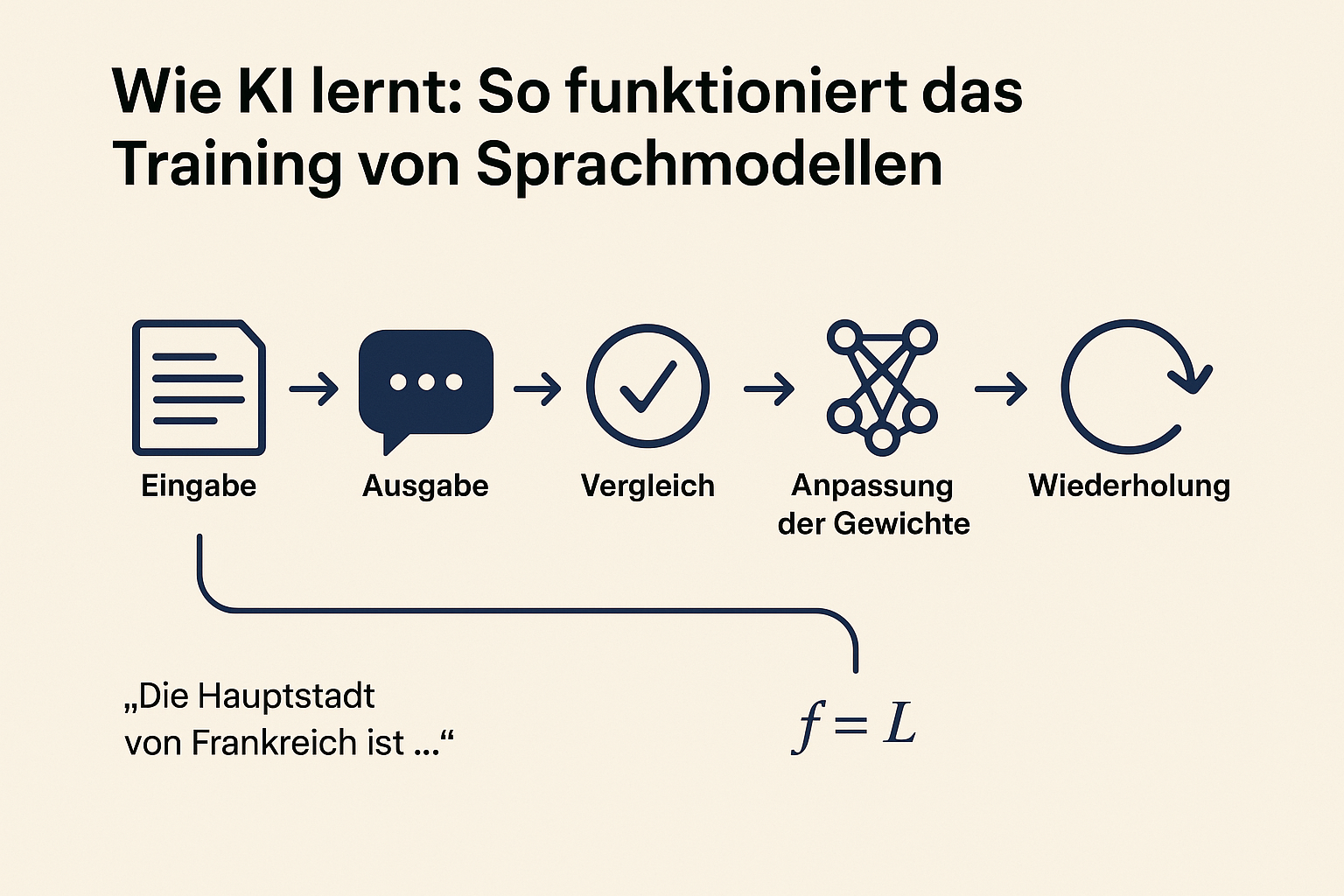

So funktioniert das Training von KI

Beim Training durchläuft das Modell Milliarden von Texten. Es versucht immer wieder, das nächste Wort zu erraten – und wenn es falsch liegt, wird es korrigiert.

Das geschieht in sechs Schritten:

- Eingabe eines Textabschnitts

- Ausgabe des nächsten Wortes

- Vergleich mit der echten Fortsetzung

- Fehlerberechnung

- Anpassung der Gewichte im neuronalen Netz

- Wiederholung mit neuen Daten

Dieser Prozess wiederholt sich millionenfach. So entsteht aus Zufall Schritt für Schritt ein System, das Muster erkennt und komplexe Sprache versteht.

Warum das Lernen der KI schwer nachvollziehbar ist

Das Entscheidende: Die KI wird nicht programmiert, sondern trainiert. Menschen geben keine Regeln vor, sondern überlassen es der Mathematik, aus Daten zu lernen.

Das Modell besteht aus Milliarden von Zahlenwerten – sogenannten Parametern. Diese bestimmen, wie Wörter und Bedeutungen miteinander verknüpft sind.

Doch: Welche Zahl was genau bedeutet, weiß niemand.

Forschende sprechen deshalb von einer „Black Box“: Wir sehen, was das Modell kann, aber nicht, wie es diese Fähigkeit entwickelt hat.

KI lernt Bedeutungen – ganz ohne Plan

Spannend ist, dass während des Trainings bestimmte Strukturen im Inneren der Modelle entstehen, die echten Konzepten ähneln. Zum Beispiel:

- „Größe“ vs. „Kleinheit“

- „Konflikt zwischen Individuen“

- Oder sogar „Golden Gate Bridge“

Diese sogenannten Komponenten sind wie gedankliche Bausteine der KI. Doch sie wurden nicht von Menschen eingebaut – sie sind durch das Training organisch gewachsen.

Warum wir noch ganz am Anfang stehen

Obwohl Sprachmodelle beeindruckende Leistungen zeigen, verstehen wir ihren Lernprozess kaum. Wir sehen die Ergebnisse – kreative Texte, kluge Antworten, komplexe Analysen – aber wir wissen (noch) nicht genau, warum das alles funktioniert.

Das macht Künstliche Intelligenz faszinierend – und zu einer der wichtigsten Technologien unserer Zeit.

Schreibe einen Kommentar